- Define teoría del cambio y usa indicadores de proceso, eficacia y efectividad para ajustar sobre la marcha, con tableros simples y accionables.

- Si es posible, aplica diseños causales (aleatorización/RDD) para atribuir efectos; cuida dosis, fidelidad de implementación y soporte docente.

- La evidencia favorece el CAL en matemáticas y, con buen diseño adaptativo y feedback rápido, también en lengua; más no siempre es mejor.

- Escala integrando en estructuras locales, cuidando inclusión, privacidad y evaluación continua para sostener resultados en el tiempo.

La tecnología educativa puede ser un catalizador formidable del aprendizaje, pero solo si medimos su efecto con rigor y actuamos en consecuencia; por eso aquí vas a encontrar cómo evaluar de forma seria si una intervención digital funciona y aporta beneficios de la tecnología educativa, qué indicadores usar, qué métodos aplicar y qué nos dice la evidencia más reciente.

Partimos de experiencias reales en escuelas de América Latina y Europa y de investigaciones publicadas en revistas de referencia sobre nuevas tendencias pedagógicas. Verás desde la construcción de una teoría del cambio y tableros de indicadores hasta ensayos controlados aleatorizados con programas de aprendizaje asistido por ordenador; todo ello con claves prácticas para llevarlo al aula sin perder de vista la equidad, la privacidad y la sostenibilidad.

Qué significa medir el impacto de la tecnología educativa

Medir impacto no es contar dispositivos ni horas de pantalla: es estimar si una intervención tecnológica provoca cambios observables y atribuibles en resultados educativos; para ello hace falta definir resultados, comparar y aislar efectos, apoyándose en buenas prácticas y en tipos de evaluación educativa adecuados.

En la práctica, evaluar un programa EdTech implica alinear objetivos, identificar poblaciones beneficiarias, recoger datos de implementación y aprendizaje y analizar las características del aula con tecnología; cuando es posible, usar diseños causales; la meta es poder responder si la tecnología aportó valor añadido sobre la enseñanza tradicional y en qué condiciones lo hizo.

También conviene diferenciar niveles de efecto: corto plazo (tras la intervención), medio plazo (al año) y largo plazo (más allá de un curso), porque algunos impactos se diluyen con el tiempo y otros se consolidan; de ahí la necesidad de seguimientos longitudinales y cohortes comparables.

Marcos de evaluación: teoría del cambio y el modelo de “cuatro en equilibrio”

Una buena evaluación nace de una teoría del cambio clara y de una sólida gestión educativa: qué insumos permiten qué actividades, qué productos generan y qué efectos producen en beneficiarios; en transformación digital escolar conviene coordinar visión, capacitación docente, recursos educativos digitales e infraestructura, manteniendo coherencia estratégica a lo largo del tiempo.

Este enfoque fue útil en una iniciativa a gran escala en Brasil, donde la hipótesis causal explícita sirvió para alinear a actores durante varios años, incluso ante eventos disruptivos; la escala permitió aprender en diversidad de contextos y fortalecer las comunidades educativas; al concretar supuestos y rutas de cambio, se facilita el uso de indicadores pertinentes y verificables para cada eslabón de la cadena.

La teoría del cambio no vive en un informe: debe conectarse con el día a día de escuelas y administraciones, con metas realistas por etapa y con responsabilidades claras en la institución educativa; si se formula bien, se convierte en la columna vertebral del monitoreo y la toma de decisiones.

Indicadores y tableros: proceso, eficacia y efectividad

El monitoreo continuo, apoyado por fichas interactivas, descansa en indicadores que cubren tres planos: de proceso (¿se hizo lo previsto?), de eficacia (¿se entregaron productos/servicios?) y de efectividad (¿cambió el comportamiento/uso/aprendizaje?); esta tríada permite ajustes ágiles durante la ejecución.

Ejemplos concretos: proceso, selección y contratación de recursos digitales; eficacia, porcentaje de alumnado registrado; efectividad, tiempo y frecuencia de uso de materiales; con datos públicos y trazas de uso se puede construir un tablero que alimente decisiones a nivel central, regional y de centro escolar y que refleje distintos tipos de innovación educativa.

La herramienta no tiene por qué ser sofisticada: excel u hojas equivalentes sirven si el tablero es claro, oportuno y accionable; lo crítico es que dé visibilidad a brechas territoriales, cumplimiento de hitos y barreras, para orientar soporte focalizado y aprendizaje entre pares. Esto es útil incluso para centros que implementan un curso en línea o programas híbridos.

Gobernanza del M&E: grupos de trabajo, comité académico y divulgación

Un grupo de trabajo de monitoreo y evaluación que reúna financiadores, implementadores y equipo analítico se vuelve el foro de seguimiento; con reuniones mensuales y tableros interactivos se detectan desafíos y buenas prácticas a replicar, reforzando la trazabilidad de decisiones y la orientación educativa.

Sumar un comité académico aporta solvencia metodológica: revisa indicadores, discute diseños y valida hallazgos; además, divulgar resultados con informes, eventos, web y microdatos fortalece la transparencia y facilita que otras jurisdicciones adapten lo aprendido.

Redes de investigación colaborativa también marcan la diferencia: la articulación de decenas de instituciones especializadas nutre estudios, mejora estándares y sostiene el interés público; de este modo, el monitoreo trasciende el proyecto y se convierte en bien público escalable.

Evaluación de impacto: diseños para atribuir efectos

Cuando el objetivo es atribuir cambios a la intervención, los diseños aleatorizados o cuasi experimentales son el referente; la asignación por sorteo, por ejemplo, crea grupos comparables y permite estimar el efecto causal del programa sobre resultados de aprendizaje medidos externamente.

El reto logístico es real: requiere línea de base, seguimiento y pruebas estandarizadas, además de blindar la implementación para evitar contaminación entre grupos; pero los beneficios son enormes, porque resuelven la eterna duda sobre si los avances se deben al software o al tiempo extra de instrucción.

En educación primaria, una práctica común es focalizar la prueba en grados iniciales, donde las habilidades básicas son más sensibles; esto ayuda a observar impactos tempranos y ajustar dosis e integración en aula para maximizar retornos pedagógicos.

Qué dice la evidencia más rigurosa sobre el aprendizaje asistido por ordenador

La literatura reciente que emplea ensayos controlados y diseños robustos coincide: los programas de aprendizaje asistido por ordenador (CAL) funcionan especialmente bien en matemáticas, donde la personalización y la retroalimentación inmediata encajan con la estructura de la materia; las revisiones sistemáticas y meta-análisis reportan efectos positivos consistentes.

En un diseño con tres tratamientos, añadir clases tradicionales extra mejoró resultados, pero el CAL igualó o superó ese avance, sobre todo cuando fue supervisado por docentes; este tipo de comparación permite aislar el valor propio del software frente al mero incremento de horas lectivas.

Cuando el CAL se integra en horario escolar, con sesiones cortas y frecuentes, se observan ganancias notables inmediatas y, aunque se reduzcan con el tiempo, persisten al menos parcialmente un año después; esto subraya la importancia de la regularidad y la práctica distribuida.

Además, combinar CAL con entrenamiento y acompañamiento docente semanal eleva el impacto, especialmente si se logra un umbral de práctica (por ejemplo, alrededor de media hora semanal por aula); la fidelidad de implementación pesa más que la plataforma en sí, de ahí que el soporte a profesorado sea palanca crítica.

Por último, cuidado con la dosis: más no siempre es mejor. La investigación sobre rendimientos decrecientes muestra que tras cierto umbral la ganancia marginal se aplana o incluso cae; diseñar la intensidad óptima de uso es clave para optimizar tiempo y recursos.

Lengua y lectoescritura con CAL: condiciones para que funcione

En lectura y escritura los resultados son más heterogéneos: algunos programas no muestran efectos, mientras que otros sí mejoran comprensión y habilidades; los rasgos que más se repiten en las intervenciones exitosas son currículo adaptativo, personalización completa del contenido inicial y retroalimentación rápida.

Los estudios que combinan estas tres características y minimizan cargas al docente tienden a destacar: plataformas con itinerarios adaptativos y feedback inmediato que se ejecutan como complemento a las tareas suelen elevar puntuaciones estandarizadas en lenguaje; la clave es que el software se adapte al progreso real del alumno.

Otro ángulo poco conocido es el impacto sobre habilidades no cognitivas: hay intervenciones breves que, además de mejorar pruebas de lengua, refuerzan perseverancia, autoconfianza y locus de control, con efectos especialmente marcados en alumnado con riesgo de dificultades específicas; medir estas dimensiones amplía la foto del impacto real.

Caso Brasil: de la implementación a la evaluación a gran escala

Brasil lanzó un programa nacional para transformar escuelas públicas mediante innovación y tecnología, con un piloto en cinco regiones que abarcó decenas de sistemas educativos subnacionales, cientos de centros, miles de docentes y cientos de miles de estudiantes; la escala permitió aprender en diversidad de contextos.

La evaluación se apoyó en una teoría del cambio explícita y en un monitoreo con indicadores de proceso, eficacia y efectividad para ir corrigiendo el rumbo durante cuatro años; se usaron tableros sencillos y accesibles para extraer señales accionables en poco tiempo.

La gobernanza del conocimiento incluyó un grupo de trabajo de M&E con todos los socios y un comité académico que asesoró sobre metodología; el proyecto además publicó informes, organizó eventos, abrió microdatos y tejió una red de investigación con decenas de instituciones que sostuvieron el aprendizaje colectivo.

La evaluación de impacto, aún en curso, comparó escuelas apoyadas con otras similares que no recibieron la intervención, aprovechando mecanismos aleatorios para la selección; el resultado esperado es verificar mejoras en pruebas de alumnado de grados iniciales y cerrar el círculo entre monitoreo operativo e impacto causal.

Caso DytectiveU: diseño, despliegue y evidencia

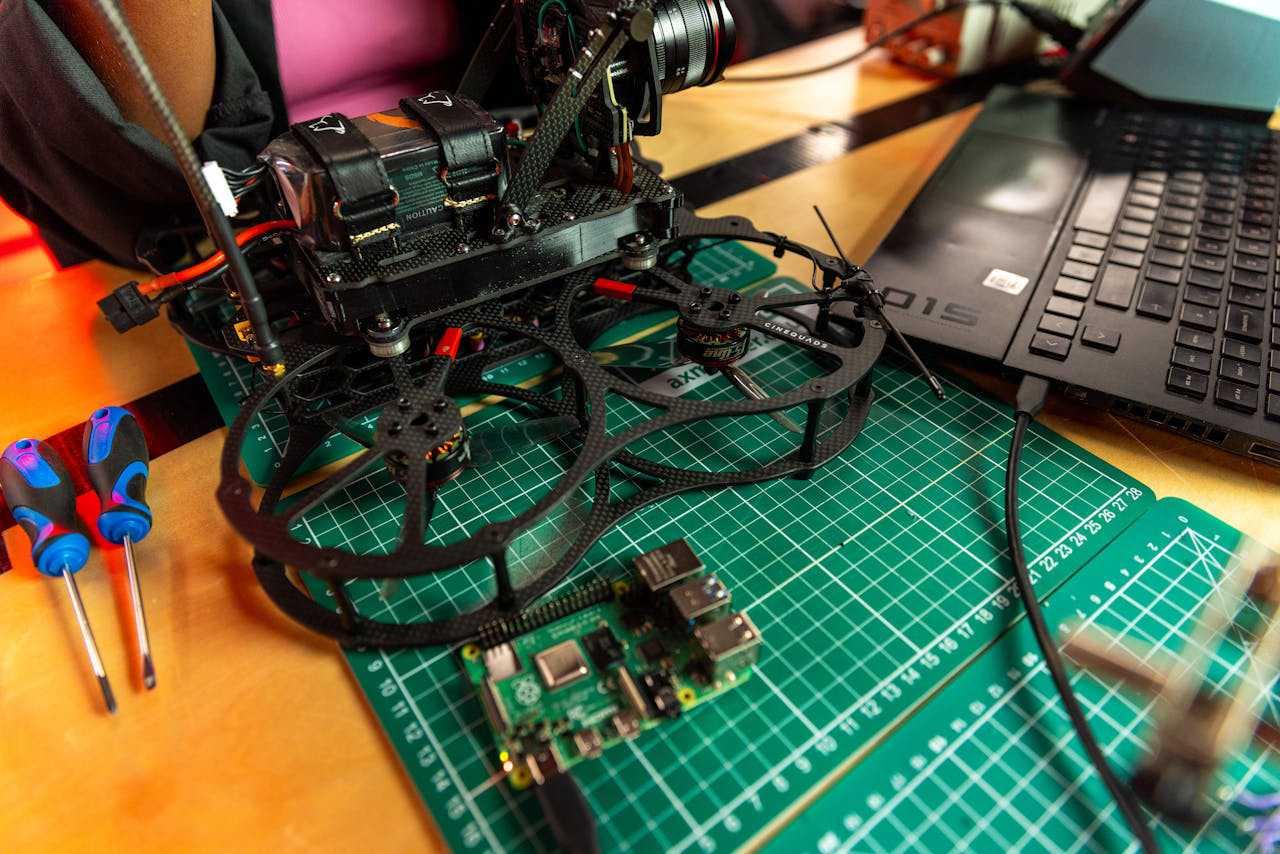

DytectiveU es un software de lenguaje orientado a 1.º-6.º de primaria, con especial foco en alumnado con dislexia; su motor adaptativo personaliza itinerarios con decenas de miles de ejercicios creados por lingüistas y psicólogos, y se apoya en recursos de procesamiento de lenguaje natural para ajustar dificultad, patrones y feedback.

El sistema recoge métricas finas (aciertos, velocidad, precisión, eficiencia) que alimentan un mapeo de habilidades cognitivas y desempeño en alfabetización, ajustando ejercicios según progreso; para estudiantes y docentes es un entorno lúdico con sesiones de unos 20 minutos que facilita práctica frecuente y motivadora.

La Comunidad de Madrid lo incorporó como complemento escolar con acceso también en hogar, escalando su uso de decenas a centenares de colegios hasta cubrir toda la red pública y concertada; este despliegue masivo aporta validez externa poco habitual en evaluaciones EdTech.

Los análisis en Madrid detectaron mejoras relevantes en áreas concretas (por ejemplo, inglés con mayor efecto en alumnas), y en Chile, con 600 estudiantes en contextos vulnerables, se observaron impactos en habilidades no cognitivas y en puntuaciones de lectura tras apenas tres meses; además, se identificó un punto óptimo de sesiones más allá del cual la ganancia marginal se reduce.

Competencia digital y contexto: qué medir además del rendimiento

El impacto de la tecnología no solo se observa en notas: también en competencia digital, actitudes y equidad; distintos trabajos han evaluado niveles de competencia digital en primaria y secundaria, factores sociofamiliares, sesgos de género y efectos de la formación docente, apoyándose en modelos como DigComp y pruebas psicométricas.

Hay evidencia de que el entorno familiar y la mediación parental influyen en la competencia digital y en el uso seguro y productivo de internet; asimismo, la formación del profesorado en TIC condiciona la integración pedagógica y los resultados, por lo que conviene medir capacidades docentes y clima digital del centro.

En evaluaciones institucionales, instrumentos estandarizados y escalas validadas permiten comparar niveles y progresos, y conviene cruzar esos datos con indicadores de uso real de recursos digitales; así se detectan brechas por género, nivel socioeconómico o territorio, activando estrategias de compensación.

Implementación en el aula: integración, inclusión, seguridad y evaluación continua

Integrar tecnología no es cambiar un libro por una app: es rediseñar experiencias de aprendizaje más interactivas, personalizadas y colaborativas; esto implica alinear objetivos curriculares, seleccionar herramientas con sentido didáctico y garantizar usabilidad y accesibilidad para todo el alumnado.

Buenas prácticas: sesiones cortas y regulares con feedback inmediato, uso de plataformas en la nube para compartir y co-crear, y tareas que aprovechen la fortaleza del medio digital (simulaciones, tutores adaptativos, evaluación formativa); el docente orquesta y el software personaliza a escala.

Si el centro aplica BYOD o dispositivos compartidos, planifica ancho de banda, normas de uso, perfiles y seguridad; selecciona soluciones que cumplan normativa de privacidad, minimicen datos y ofrezcan controles parentales; además, educa en ciudadanía digital para anclar hábitos responsables y seguros.

La inclusión es indeclinable: herramientas con opciones de accesibilidad, contenidos con lectura fácil y apoyo multimodal, y adaptaciones para NEE; evalúa periódicamente barreras y apoya a quienes lo necesiten para que la tecnología sea un igualador y no un amplificador de brechas.

Por último, evalúa el impacto en el propio centro con métodos mixtos: pruebas, rúbricas, proyectos, encuestas de compromiso y análisis de trazas de uso; define una batería compacta de indicadores y revísala en ciclos mensuales con el equipo docente, cerrando el bucle de mejora continua basada en datos.

Métodos y pasos operativos para medir impacto en tu programa

1) Alinea una teoría del cambio con metas y poblaciones; 2) define indicadores de proceso, eficacia y efectividad; 3) establece un tablero simple con metas temporales; 4) prueba a pequeña escala y ajusta; 5) cuando puedas, usa aleatorización o diseños cuasi experimentales; 6) comunica resultados y escala con fidelidad.

Si buscas causalidad y no puedes aleatorizar, explora discontinuidades, emparejamientos o diferencias en diferencias con buenos datos de base; documenta supuestos y estrésalos con sensibilidad; más vale una estimación modesta pero honesta que un efecto enorme sin identificación creíble.

Define desde el principio qué pruebas o métricas externas usarás (matemáticas, lectura, ortografía, asistencia, clima, competencia digital) y cuándo medir; incluye subgrupos (por sexo, nivel inicial, NEE) para ver heterogeneidad; reporta no solo medias, también distribuciones y percentiles.

Planifica sostenibilidad: ¿qué pasa cuando se retira el apoyo externo?, ¿puede operar con personal existente?, ¿qué costes recurrentes hay?; los programas que se integran en estructuras y liderazgos locales tienen más probabilidades de perdurar, con directivos que impulsan la gestión instruccional.

Una intervención EdTech bien medida permite separar el brillo de la novedad de los aprendizajes reales, optimizar la dosis, combinar tecnología y pedagogía con sentido y replicar solo aquello que funciona en condiciones diversas; con una teoría del cambio viva, indicadores útiles, diseños causales cuando sea posible y una gobernanza que aprende, la tecnología deja de ser un fin en sí mismo para convertirse en un medio eficaz y equitativo para mejorar el aprendizaje, siempre que docentes, datos y diseño remen en la misma dirección.