- Evalúa primero el encaje pedagógico y el grado de interactividad real.

- Usa listas de control mixtas para criterios técnicos y didácticos.

- Pilota, recoge evidencias y decide si los beneficios superan las limitaciones.

La irrupción de las TIC en los centros educativos ha sido más intensa en la gestión y la administración que en la propia práctica pedagógica. Durante años, se han priorizado herramientas adaptadas del mundo empresarial —baratas y ya amortizadas— para cubrir la burocracia escolar, mientras la dimensión didáctica quedaba en manos del profesorado, que debía arreglárselas para adaptar recursos generalistas o crear materiales con programas de autor.

Hoy la tendencia editorial avanza hacia materiales digitales en masa y espacios virtuales para docentes, con contenidos curriculares por materias y niveles. Sin embargo, si nos limitamos a consumir lo que dicta una plataforma, el docente quedaría reducido a mero ejecutor. Por eso, es crucial que el software educativo permita adaptación sencilla por parte del profesorado: ajustar tiempos, secuencias, actividades y enfoques sin ser experto informático. A partir de aquí, conviene preguntarse cómo debe ser ese software, qué consecuencias pedagógicas se derivan de su diseño y con qué criterios conviene evaluarlo.

Diseño del software educativo y su impacto pedagógico

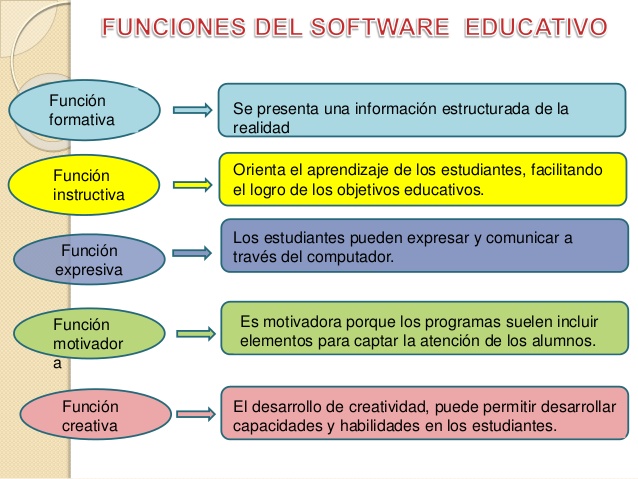

El software educativo nace con propósito didáctico: no es una aplicación cualquiera, sino un recurso pensado para ser utilizado por la comunidad educativa. Esto implica que su estructura, objetivos y metodología quedan anclados a una teoría del aprendizaje subyacente. En informática no existe recurso “no interactivo”: la interacción es condición de posibilidad. La clave está en el grado y la calidad de esa interactividad, y en cómo se orquesta pedagógicamente.

Desde una mirada conductista, el aprendizaje se entiende como reproducción fiel de contenidos y procedimientos definidos a priori. En términos de software, esto suele traducirse en actividades de respuesta cerrada con realimentación limitada, rutas fijas y un margen de acción mínimo. No sorprende que una parte sustancial del mercado siga esta lógica: cuesta poco producir secuencias estructuradas, útiles para automatizar y entrenar, pero con poco espacio para la exploración y la construcción personal.

El enfoque constructivista, en cambio, persigue que el alumnado construya significado a partir de múltiples fuentes, con apoyos, andamiajes y participación activa. La evolución de la Web 2.0 favorece este modelo: el estudiante integra puntos de vista diversos, aporta su voz, coopera y genera conocimiento con otros. Así, herramientas como Scratch facilitan la investigación guiada, el contraste de perspectivas, la coautoría y la autonomía progresiva, en línea con propuestas como las de Coll y colaboradores sobre la práctica constructivista en el aula.

Este giro metodológico recoloca el papel docente: menos transmisor y más orientador, curador de recursos y diseñador de experiencias. Para que no se diluya la profesionalidad del profesorado, las aplicaciones deben permitir personalizar contenidos, secuencias y criterios de evaluación, además de integrarse en el ecosistema del aula (programación, tiempos, proyectos, plataformas). No basta con “usar” un recurso; hay que poder adaptarlo sin barreras técnicas.

Requisitos mínimos para que merezca la pena

Antes de evaluar en profundidad, cualquier herramienta debería cumplir unas condiciones de partida que faciliten su adopción real en el aula. Si no se alcanzan, probablemente no compense el esfuerzo de integración.

- Uso sencillo y aprendizaje rápido por parte del docente y del alumnado.

- Capacidad de adaptación a las circunstancias específicas del aula (ritmos, necesidades, contenidos).

- Integración natural en la programación didáctica, sin forzar la práctica.

- Vinculación a un espacio virtual propio del profesor, donde gestionar contenidos y actividades.

Incluso cumpliendo estos mínimos, el mejor modo de discernir si un software conviene es evaluarlo con criterios claros. El diseño (conductista o constructivista), el grado de interactividad o la autonomía que habilita ofrecen pistas para decidir su encaje didáctico, pero hace falta un proceso de evaluación que reduzca sesgos y proporcione evidencias.

Evaluación del software educativo: propósitos y enfoque

Desde una perspectiva docente práctica (y, por qué no, crítica), ningún recurso entra en el aula “por decreto”. El profesorado sopesa beneficios e inconvenientes, contrasta promesas con uso real y busca evidencias antes de “casarse” con una herramienta. La evaluación del software no es un trámite: es una garantía de pertinencia pedagógica.

La primera finalidad de la evaluación es formativa: ayudar a mejorar el programa. Esto interesa a los desarrolladores, pero también a los centros que pueden retroalimentar a proveedores con hallazgos sobre usabilidad y aprendizaje. Iterar es clave: las tecnologías cambian rápido y las necesidades educativas, también.

Un segundo propósito es comprobar la eficacia instructiva. Aquí entran las comparaciones: entre programas similares y entre el software y otros medios no digitales. No se trata de “usar por usar”; si una metodología analógica ofrece mejores resultados en un contexto concreto, la tecnología no tiene por qué imponerse.

La observación directa es el tercer eje: mirar lo que sucede cuando se utiliza el programa. Puede que el software persiga un objetivo, pero alcance otros no previstos (para bien o para mal). Registrar interacciones reales —tiempos, errores, apoyos requeridos, motivación— permite descubrir efectos emergentes que no aparecen en folletos ni demos.

La cuarta función es predictiva: valorar características antes de la compra o adopción para anticipar cómo se comportará en el aula. En el ámbito tecnológico, el profesorado parte con desventaja respecto a otros recursos conocidos; por su complejidad, conviene destinar más tiempo, utilizar instrumentos específicos y evitar decisiones precipitadas. En esta línea, enfoques de evaluación de programas (Cepeda) y perspectivas de cuarta generación (Lincoln y Guba) invitan a incorporar a las partes interesadas, reconocer la pluralidad de valores y equilibrar métodos cuantitativos y cualitativos (Martínez) para una visión más rica.

En la práctica, esto se concreta en recoger datos variados: resultados de aprendizaje, satisfacción, incidencias técnicas, tiempos de tarea, y evidencias cualitativas (diarios de clase, entrevistas breves, rúbricas y notas de campo). Esta triangulación ayuda a separar impresiones de hechos y a sostener la toma de decisiones con argumentos verificables.

Criterios y fórmulas para seleccionar y valorar

Antes de puntuar nada, conviene encuadrar la herramienta: ¿qué tipo de aplicación es (tutorial, simulador, gestor de práctica, base de datos, creador de actividades)? ¿Cuál es su finalidad instruccional? Esta clasificación inicial aclara expectativas y evita pedirle a un programa lo que no está diseñado para ofrecer, mejorando la justicia de la evaluación.

El segundo paso es aplicar un método lo más objetivo posible, que valore tanto atributos técnicos como pedagógicos. Las listas de control (checklists) son ideales para ello: descomponen el análisis en ítems observables, minimizan sesgos (como la estética, la publicidad o la simpatía por una marca) y garantizan que no se olvida ningún aspecto clave. Pueden ser cualitativas, cuantitativas o mixtas, con preguntas generalmente cerradas pero abiertas a observaciones contextualizadas.

Dimensión técnica (informática)

- Grado de interactividad real con el usuario (tipo de tareas, caminos alternativos, retroalimentación).

- Funcionamiento general: facilidad de uso, estabilidad, compatibilidades, tiempos de carga y respuesta.

- Manual o centro de ayuda claros y accesibles; tutoriales iniciales.

- Compatibilidad con otros sistemas y entornos (SO, navegadores, dispositivos) y con multimedia.

- Recursos multimedia empleados (texto, audio, vídeo, animaciones) y su calidad.

- Naturaleza del sistema: tutorial, simulador, práctica guiada, gestor de contenidos, base de datos, etc.

- Capacidad de trabajo en red: multisesión, colaboración, sincronización.

- Rendimiento y velocidad bajo distintas condiciones de red y hardware.

- Servicio de mantenimiento y atención al cliente: tiempos de respuesta, actualización, soporte.

Estos elementos determinan la experiencia de uso y la viabilidad técnica en el centro. Un software brillante en pedagogía pero con cortes frecuentes o mala compatibilidad acabará infrautilizado.

Dimensión pedagógica

- Modelo de aprendizaje que promueve (conductista, constructivista, mixto) y coherencia interna.

- Grado de cumplimiento de objetivos didácticos definidos y trazabilidad del progreso.

- Adecuación al nivel evolutivo, contexto socioeducativo y diversidad del alumnado.

- Metodología: andamiaje, secuenciación, diferenciación, trabajo autónomo o colaborativo.

- Disponibilidad de guía didáctica con orientaciones de uso e integración curricular.

- Profundidad, rigor, estructuración y calidad de los contenidos.

- Procesos cognitivos activados: psicomotricidad fina, memoria, comprensión, cálculo, análisis, orientación espacial, expresión oral, etc.

- Áreas curriculares a las que se adscribe y posibles transferencias.

- Grado de autonomía que permite y mecanismos de autorregulación.

- Propuestas de evaluación integradas: ítems, rúbricas, informes, analíticas.

- Capacidad de integrarse en una plataforma virtual de aprendizaje (LMS) u otros entornos del centro.

Tras aplicar los criterios, muchas escuelas optan por ponderarlos (por ejemplo, mayor peso al encaje curricular y a la accesibilidad) y establecen umbrales mínimos. Las listas de control pueden empezar tomando referencias existentes, como las tipos de innovación educativa, y, con la experiencia, el equipo docente puede construir su propio instrumento, más afinado a su realidad.

Hay fórmulas complementarias que aportan valor: pruebas piloto con un grupo reducido, recogida de feedback de estudiantes y familias, y comparativas A/B frente a otros recursos. Integrar datos del aula (calificaciones, participación, tiempos) con notas cualitativas proporciona una imagen más completa y disminuye el riesgo de decisiones basadas en intuiciones momentáneas.

En la decisión final conviene listar ventajas y desventajas principales: se adopta el programa si compensa asumir sus inconvenientes porque los beneficios son claramente superiores. Si no es el caso, se continúa la búsqueda. Esta prudencia evita el “síndrome del juguete nuevo” y prioriza la sostenibilidad pedagógica en el tiempo.

Una vez elegido e implantado, la evaluación no termina: durante su uso debe mantenerse una evaluación formativa (ajustes sobre la marcha, identificación de barreras, mejora de secuencias) y, al cierre de un ciclo, realizar una evaluación final o sumativa para decidir continuidad, cambios o retirada. Nadie mejor que el profesorado sabe que, en educación, el juicio más sólido nace de la práctica situada.

El componente humano es decisivo. El desarrollo de competencias docentes para seleccionar, adaptar y evaluar recursos digitales (como subraya la literatura sobre competencias del profesorado) marca la eficacia real del software. Asimismo, procesos de ingeniería de software educativo ofrecen marcos para diseñar y analizar herramientas con criterios de usabilidad y pedagogía integrados, mientras experiencias de desarrollo e implementación en centros muestran tanto el potencial como los retos de infraestructura, acompañamiento y soporte.

Por último, la perspectiva evaluativa de “cuarta generación” invita a abrir la conversación a todas las partes interesadas (estudiantes, familias, docentes, equipos directivos), reconocer que los valores son múltiples y que los contextos importan. Complementar métodos cuantitativos con enfoques cualitativos bien diseñados —entrevistas cortas, grupos focales, observación— ayuda a entender por qué ciertas funcionalidades funcionan o no en un entorno específico y a tomar decisiones contextualizadas sobre adopción y mejora.

Cuando se alinean un diseño pedagógico consistente, una base técnica sólida, la posibilidad real de adaptación docente y un proceso de evaluación riguroso, el software educativo deja de ser un “extra” para convertirse en un aliado. La tecnología no sustituye la pedagogía: la potencia cuando se pone al servicio de objetivos claros, de la diversidad del aula y de una cultura de mejora continua en la que el profesorado ejerce su liderazgo profesional.